-

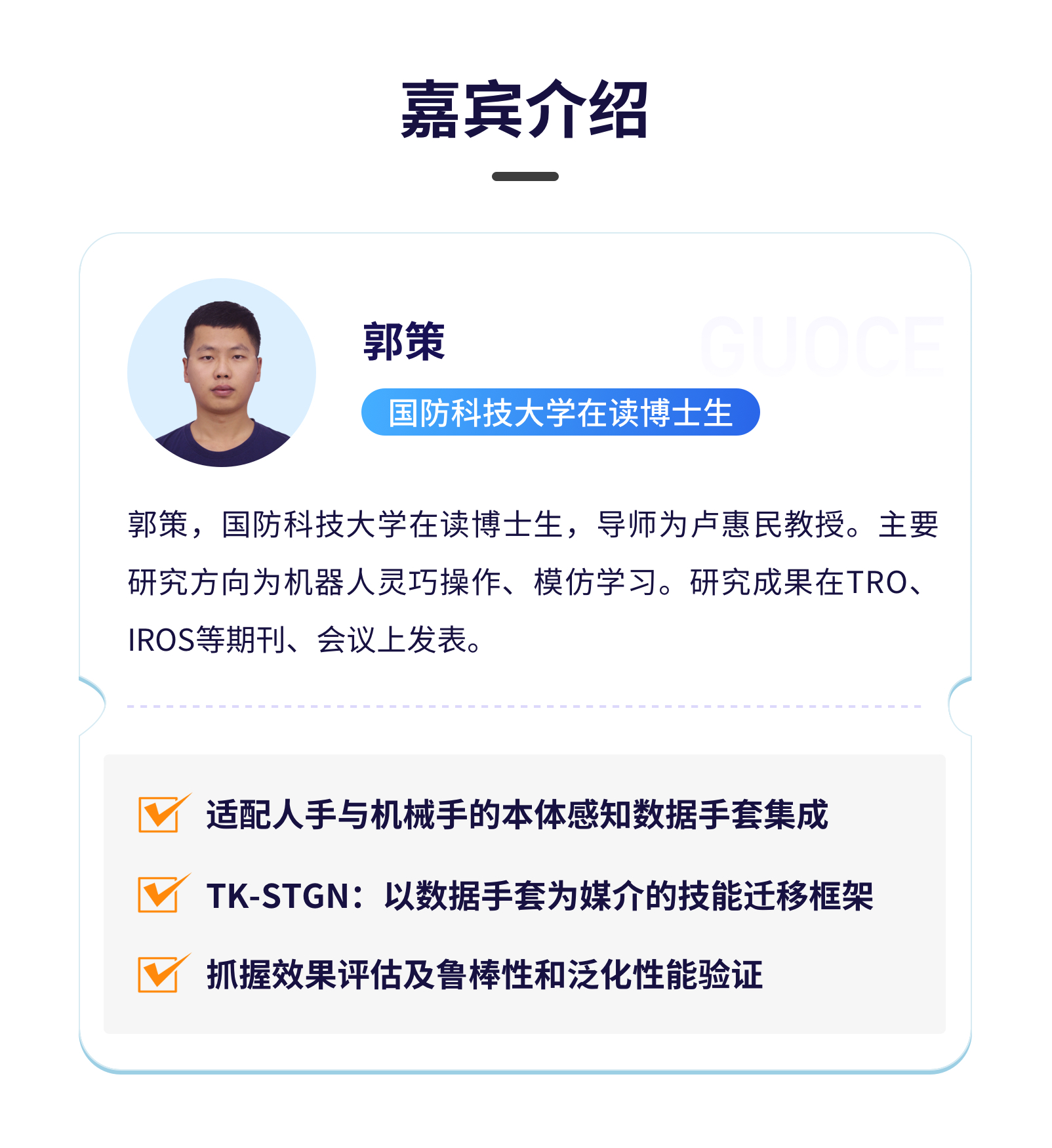

开课时间

2025.10.14 20:00

-

课程时长

87分钟

-

学习人数

2938人次学习

添加助教,领取课件

- 课程介绍

- 课件领取

- 相关课程

2025.10.14 20:00

87分钟

2938人次学习