-

这个是根据求导出来的吧。用E(R)对H(a)求导,然后区分a是否是当前动作可以得到两个迭代式。

注意E(R)可以写成与相关H(a)的表达式。

-

第三次作业

——来自《强化学习理论与实践- 第二期》·17浏览

同学你好:

对所有状态的值函数的平均值画一条曲线。

-

第二讲 编程题 最后一题有疑问

——来自《强化学习理论与实践- 第二期》·17浏览

策略并不是一定要执行的,策略是一个表,存在agent内部,碰到了某一个状态再查这个表就行了。没碰到这个状态也没关系哈。

具体的策略问题,可以参考回答:

-

确定性策略

——来自《强化学习理论与实践- 第二期》·42浏览

-

确定性策略

——来自《强化学习理论与实践- 第二期》·42浏览

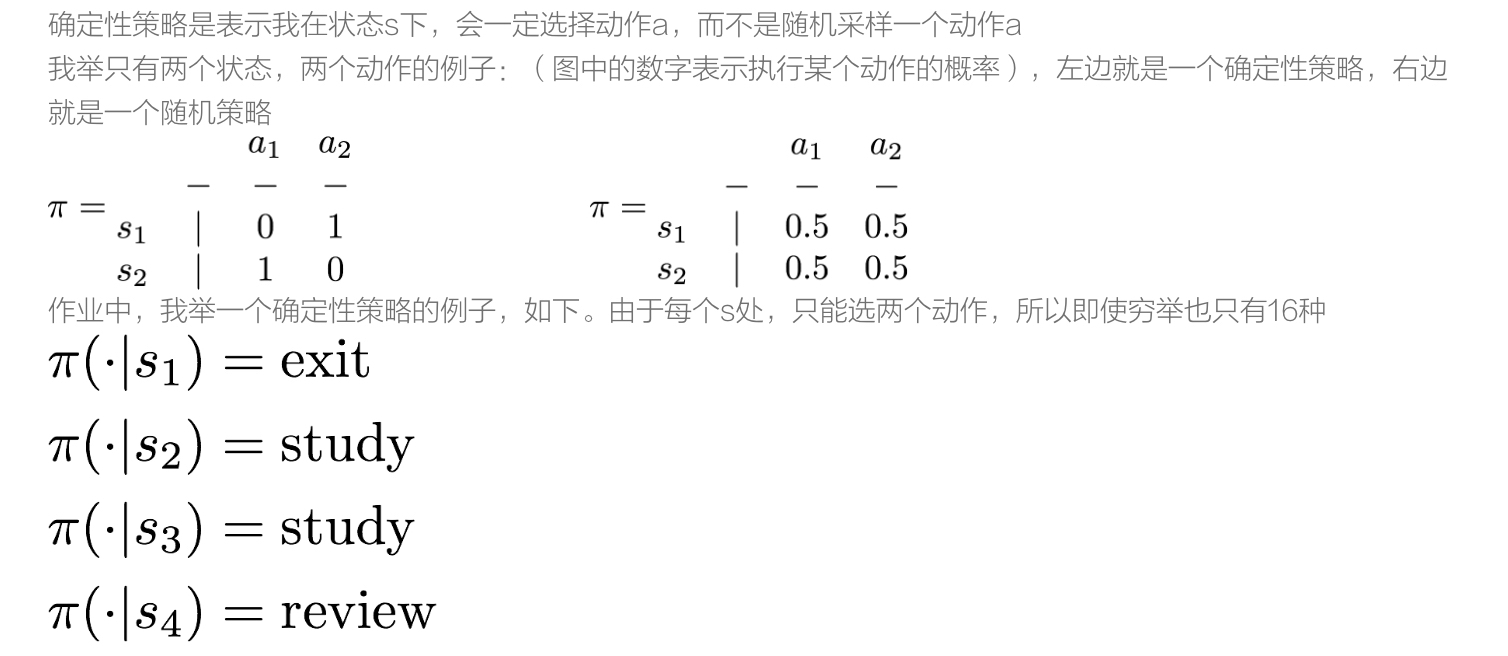

正如课件中所述,确定性策略的表达可以是一个向量。只有16种的原因是因为这样的向量只有16个

-

确定性策略

——来自《强化学习理论与实践- 第二期》·42浏览

@ccww 没有关系啊。策略并不是一定要执行的,策略是一个表,存在agent内部,碰到了某一个状态再查这个表就行了。

状态不确定无所谓的,等到下一个时刻环境通过采样会给你返回一个状态,这个时候按照这个状态做动作即可。

-

同学你好:

强化学习中随机性有即可能指策略是随机的,也有可能指环境模型是随机的。一般来说,我们谈到随机的mdp,指的还是环境模型随机,即指状态转移是随机的。

即你在状态s下,做了动作a,所能到达的后继状态s'是随机的。

-

@zhr9651 很多情况下,状态转移都是不确定的。比如你跟别人下围棋,我们把对方视为环境,当你下了一个棋子之后,对方给的反馈就是随机的。你只能估计对方在某个地方落子的概率,而无法得到准确的值。

-

关于DQOmemory问题

——来自《强化学习理论与实践- 第一期》·11浏览

同学你好:

这个倒不用。DQN中还是允许对memory重复采样的。

-

策略梯度目标函数如何构建?

——来自《强化学习理论与实践- 第一期》·15浏览

同学你好:

这里的J是一个真实值,真是使用的时候可以用MC去估计,比如稳定一个策略不变不停地采样,然后计算平均回报值。

-

关于策略改进的问题

——来自《强化学习理论与实践- 第一期》·18浏览

同学你好:

动态规划的策略迭代中,是不需要探索的,原因是我们已知了状态转移概率。只有当使用样本备份时,才会需要探索,比如MC的方法以及时间差分的方法。

-

同学你好:

首先非常抱歉,之前把你的问题看漏掉了,因此回复的时间较晚,望见谅。

1. 算法2中,当pi(At|St)=0时,W就会等于0。这种情况下对应的在状态St下,如果使用策略pi,动作At永远不会执行,但是对于行为策略来说,是有可能执行的。

2. 算法3中描述的事情和算法2类似,只是考虑到了pi是一个取max的确定性策略(贪婪的策略)如果At不是那个贪婪的动作,也就代表At在pi中永远不会被执行,即也就相当于W=0了