-

策略梯度中参数更新问题

——来自《强化学习理论与实践- 第一期》·32浏览

@陈达贵 老师,公式里面的pi(theta)是指action的一个分布,还是算one-hot?

-

策略梯度中参数更新问题

——来自《强化学习理论与实践- 第一期》·32浏览

-

策略梯度中参数更新问题

——来自《强化学习理论与实践- 第一期》·32浏览

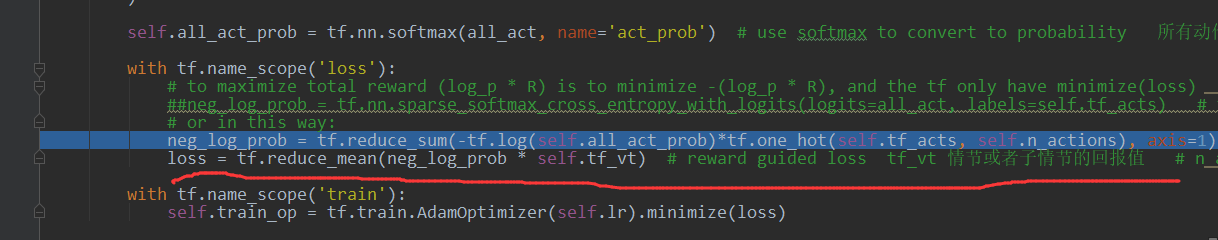

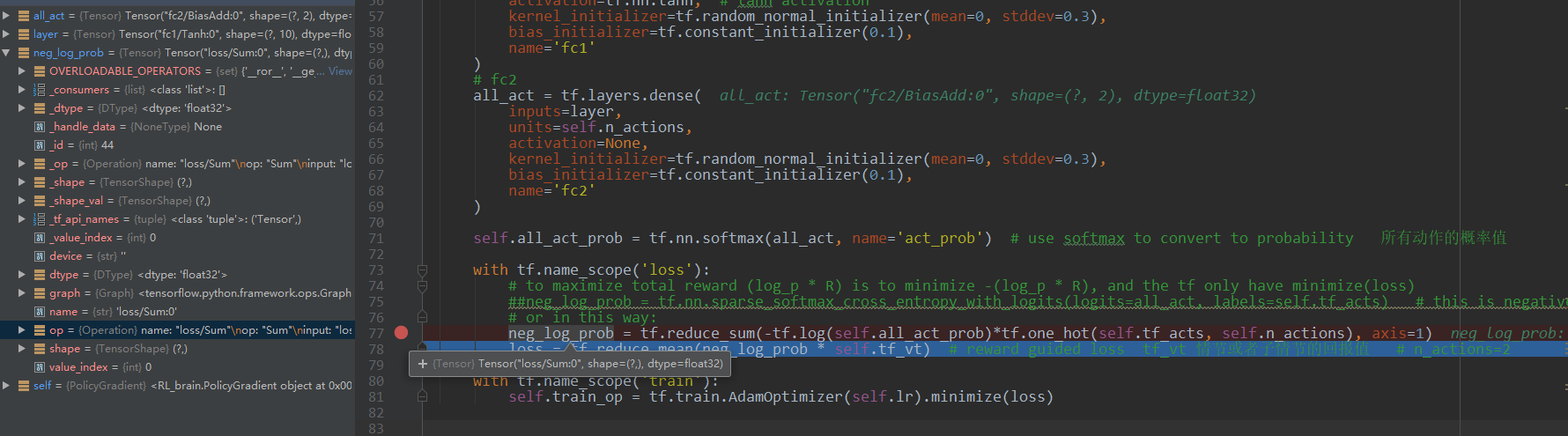

@陈达贵 不好意思啊老师,这里还是有点不太理解。您说公式里面的pi(theta)输出的是一个动作的概率分布。但是用onehot就挑出了一个呢?比如说动作=[p(A)=0.3,p(B)=0.7],也就是all_act_prob=[0.3 0.7],

one_hot=[[1 0]T [0 1]T],one_hot是怎么挑选出pi在B处的输出概率的?

PS:这里pycharm我想打断点查看self.all_act_prob,neg_log_prob的值总是查看不了,就像下图。可能是我方法不对,有没有什么方法能查找任何一个自己想看的值?麻烦老师!

-

策略梯度中参数更新问题

——来自《强化学习理论与实践- 第一期》·32浏览

@陈达贵 嗯嗯明白了,谢谢老师!

-

epsilon-greedy编程

——来自《强化学习理论与实践- 第一期》·20浏览

-

epsilon-greedy编程

——来自《强化学习理论与实践- 第一期》·20浏览

@陈达贵 明白点了。老师那下划线的句子的执行顺序是什么啊?从左往右还是从右往左?value_里存了四个值,执行if value_=np.max(value_)会报错啊

-

epsilon-greedy编程

——来自《强化学习理论与实践- 第一期》·20浏览

@陈达贵 明白了,谢谢老师!!

-

求出各个状态的最优V函数后,如何得出最优策略?

——来自《强化学习理论与实践- 第一期》·28浏览

@陈达贵 嗯嗯明白了,谢谢老师!