-

这样一套流程搭下来无人机续航多长时间啊?

——来自《从0制作自主空中机器人- 第二期》·26浏览

续航时间一二十分钟

-

这是因为模型部署过程中,如果增加了int8量化这个环节,那么也会增加反量化这个环节,反量化也会占用时间损耗。

此外,int8矩阵乘法与fp16矩阵乘法相比,前者会快,但是并不是严格两倍关系,这取决于硬件底层的实现和软件层面(比如CUDA)的实现。

-

apollo社区无法登录

——来自《Apollo自动驾驶技术详解25讲- 第一期》·6浏览

你好,这个问题,我们反馈给Apollo社区的工作人员。尽快给您回复

-

为何要加入+1的神经元

——来自《深度学习理论与实践(视觉方向)- 第八期》·10浏览

不是加1,是加了偏置项b吧?

-

CRFNet没讲啊,就给放了个视频。。

——来自《多传感器融合感知- 第一期》·7浏览

您好,感谢您的反馈。融合感知的课程目前正在迭代,预计两个月的迭代周期。迭代完成后,会同步更新到这一期。

-

什么时候开始更新12章以后

——来自《线性代数几何意义- 第三期》·10浏览

您好,现在在准备第12章节的试录制,尽快推进哈。

-

Ego-planner 可以基于激光雷达实现吗?

——来自《自主旋翼无人机导论- 第一期》·70浏览

是说,用激光雷达扫描建图或者障碍物检测吗?

-

这个代码到哪里下载阿

——来自《移动机器人运动规划- 第七期》·21浏览

您好,Fast-planner和Ego-planner的代码,在github上搜一下,都是开源的。

-

请问什么时候能更新完毕呢?谢谢

——来自《线性代数几何意义- 第二期》·20浏览

您好,目前基本是2-3周一章节的速度更新。

-

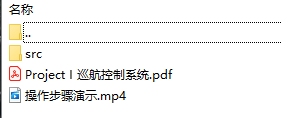

如何编译每章节提供的工程代码?

——来自《自动驾驶控制与规划- 第一期》·73浏览

课程Project I中的压缩包内,给大家提供了操作演示的视频。如下图中的“操作步骤演示.mp4”。

-

多观测下的融合策略

——来自《多传感器融合感知- 第一期》·14浏览

多个观测量的情况,融合方法有两种,一种是集中式卡尔曼滤波,一种是分布式卡尔曼滤波。

对应课程中讲到的两种方式:

(1)集中式是将所有传感器观测方程合并成一个高维的观测方程;

(2)分布式是采用加权的方法,可以分别将多个观测估计出来的状态进行加权。 -

求推荐一个点云数据做实例分割的开源算法

——来自《多传感器融合感知- 第一期》·9浏览

可以看一下LidarSeg

-

这个很常见,基本上实际工程上都会先做下采样。

但是下采样之后依然是继续用各种匹配算法,ICP这种简单粗暴的也好,提取特征的也好,深度学习的也有。但是下采样也只是个前处理。

ICP算法现在也有很多变种,比如点到点的ICP,点到线的ICP (PLICP),点到面的ICP (Point-to-Plane ICP),面到面的ICP (Plane-to-Plane ICP),Normal Iterative Closest Point (NICP)等。在工程中使用ICP算法时,要注意选择用哪些点去进行ICP,附件中是之前看过的一篇文章,着重讲解了他们如何选择ICP。

-

三者前融合的论文,比较少,没有值得推荐的论文。可能的原因在于:Lidar的点云比Radar要稠密,一般用Lidar前融合就不用Radar了。

-

根据图像估计BEV下的x和y

——来自《多传感器融合感知- 第一期》·8浏览

工程上和算法上都有办法实现:

(1)工程上,假设地面是平的或者假设已知车辆宽度等基础上,可以用来反向估计3D位置。可以搜索关键词“单目测距”;

(2)算法上,可以从图像中直接估计3D位姿,参考mono3D算法。

-

RGB-D和lidar融合有哪些SOTA的方法?

——来自《多传感器融合感知- 第一期》·14浏览

前融合可以看一下LaserNet++和PointPainting这两个方法

-

关于目标匹配中,权重计算的问题

——来自《多传感器融合感知- 第一期》·13浏览

权重矩阵是通过3D/2D框的iou算的,就是匹配算法前面一张PPT。

不是所有的都能匹配上。工程上,对于观测对象没匹配上的,我们通常会积累两三帧观测,然后在状态中,新增一个物体实例,后面的观测对象就跟这个新增的物体进行匹配。

对于没有匹配上的状态对象,会给它维护一个生命周期,如5帧,如果5帧内都没有这个对象的观测,就从状态对象列表中删除。中间如果出现,就正常更新,并增加生命周期长度,生命周期长度上限就是5。图像上并不意味着没有3D信息,实际上现在很多厂商都可以以一定的误差,恢复3D的位置和3D的框,所以不是所有的传感器数据都需要投影到图像上。

只有那些需要用到图片域中特征的匹配,才需要投影到图像域,如分割的结果。对于匹配不上的节点,就认为感知系统以前没看到过,或者当前帧传感器没有看到,就可以了。按照上面我说的方式去更新。

-

有开源的毫米波雷达和相机数据集的Rosbag吗?

——来自《多传感器融合感知- 第一期》·16浏览

现成的没看到过,可以自己转一下nuscenes,https://github.com/clynamen/nuscenes2bag

-

纯视觉SLAM领域有哪些SOTA的方法?

——来自《多传感器融合感知- 第一期》·20浏览

ORBSLAM2在纯视觉的方案里还是最好的,ORBSLAM3主要做了与IMU的融合,然后地图方面在论文里说,从理论上做了一些改进,但是实际测下来的效果,我觉得不如ORBSLAM2。

答案来自腾讯的自动驾驶工程师

-

纯视觉SLAM领域有哪些SOTA的方法?

——来自《多传感器融合感知- 第一期》·20浏览

@秦大帅 实际测下来的效果,我觉得不如ORBSLAM2,在KITTI排行榜上的算法,在实际中应用效果怎么样,是有待验证的。